Kan ik A/B-testen op mijn site?

Conversie-optimalisatie raakt steeds meer ingeburgerd. En dus word je in blogs regelmatig aangespoord tot A/B-testen. Maar heeft jouw site genoeg verkeer voor een betrouwbare A/B-test? En kun je ook testen op een site met weinig verkeer? A/B-testen is een krachtige methode om je site te verbeteren. Door structureel onderdelen van je pagina’s te testen en verbeteringen door te voeren verhoog je je conversie: meer leads, meer downloads, meer doorkliks. Met tools als VWO, Unbounce en Content Experiments in Google Analytics kan echt iedereen een A/B-test starten. Maar zo’n test heeft alleen zin als je de resultaten kunt vertrouwen. Hoe bepaal je dat?

Hoeveel verkeer heb ik nodig voor een A/B-test?

Voor een goede test heb je voldoende bezoekers nodig. Hoeveel genoeg is voor een A/B-test, hangt vooral af van het effect van de wijziging. Hoe kleiner de impact, hoe meer bezoekers je nodig hebt om het aan te tonen. Als vuistregel kun je zeggen dat je ongeveer 1000 unieke bezoekers per week moet hebben om een A/B-test te kunnen draaien. Maar de praktijk, die is iets complexer.

Wanneer is een test betrouwbaar?

Om te bepalen hoeveel verkeer je nodig hebt, hoe lang de test moet lopen en of je uitslag betrouwbaar is, let je op een paar factoren:

- Betrouwbaarheidsinterval

- Steekproef

- Effectgrootte

- Testduur

- Conversieverdeling

Door hierop te letten, vermijd je veel gemaakte fouten.

Betrouwbaarheidsinterval

Bij een A/B-test kijk je hoe een aangepaste variant van een pagina presteert ten opzichte van het origineel. Daarbij is het belangrijk dat je uitslag significant is. Dit betekent dat je met een bepaalde zekerheid kunt zeggen dat de testuitslag niet op toeval berust. In test tools heet dit ook wel ‘chance to beat the control version’. Vaak wordt een minimum van 95% of 99% aangehouden. Een significantie van 99% betekent dat je er in 99 van de 100 gevallen van uit kunt gaan dat de uitslag overeenkomt met je verwachtingen. Hoe hoger, hoe beter dus.

Toch zegt significantie alleen niet alles. Krijgt je testvariant tijdens het begin van de test heel veel conversies en de controlevariant maar enkele? Dan is de uitslag al snel significant. In testsoftware wordt deze vaak zelfs al als winnaar aangeduid. Maar beëindig je op dit moment de test, dan loop je het risico dat je de verliezer als winnaar aanwijst! Goede kans dat je nog te weinig bezoekers hebt voor een valide uitslag. Kijk daarom niet alleen naar de significantie, maar ook naar de grootte van de steekproef.

Steekproef (‘sample size’)

Hoeveel bezoekers je nodig hebt, hangt af van het aantal conversies (doorkliks, bestellingen, downloads) op je site en hoe groot het effect van je wijziging is. Eigenlijk weet je dat dus pas tijdens de test. Gelukkig kun je vooraf een schatting maken van de benodigde bezoekers met een online sample size calculator. Uiteindelijk gaat het vooral om het aantal conversies. Streef er naar om in je test minimaal 100 conversies te behalen, of als echte ondergrens minimaal 25 conversies per variant. Bij minder data is de kans simpelweg te groot dat de uitslag op toeval berust!

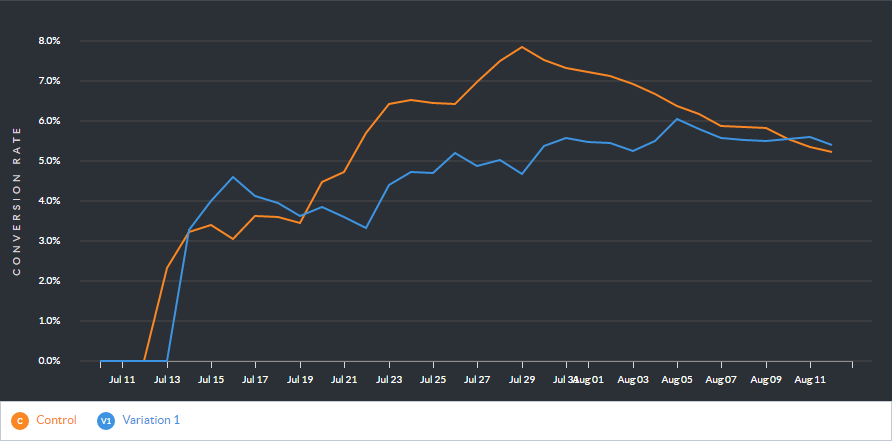

Vaak gaan bij de start van een A/B-test de controlevariant en de testvariant afwisselend aan kop. Dit uit zich in een grafiek met elkaar kruisende lijnen: kenmerkend voor een test die meer conversies nodig heeft. Had je bij onderstaand voorbeeld na twee weken besloten dat de controle (oranje) de winnaar was, dan had je er waarschijnlijk naast gezeten!

Effectgrootte

De impact die je wijziging heeft, is bepalend voor de sample size die nodig is. Hoe groter het effect, hoe minder bezoekers je nodig hebt om een winnaar aan te tonen: een compleet andere landingspagina heeft misschien wel een effect van 100% op de conversieratio, een wijziging in een buttonkleur misschien maar 10%. Daarom moet je bij het berekenen van de sample size altijd de verwachte effectgrootte opgeven (het ‘Minimal Detectable Effect’).

Blijkt het bereikte effect tijdens de test alsnog heel klein, dan heb je dus meer conversies nodig om een winnaar aan te wijzen. In dat geval is het handig om tussendoor de significantie te checken.

Testduur

Hoe lang je een A/B-test moet laten lopen is een lastige keuze. Sowieso wil je minimaal hele weken testen, om de invloed van verschillende dagen van de week te elimineren. Gezien het vaak grillige verloop aan het begin van een test is het ook slim om minimaal twee of drie weken te testen, zodat beide varianten voldoende vertoningen hebben gehad. Bij conversies waar een lange oriëntatie aan voorafgaat, wil je misschien een nog langere periode testen, zodat een hele aankoopcyclus binnen de testduur valt.

Uiteindelijk is de testduur vooral een logisch gevolg van de benodigde steekproef en het verkeer. Heb je 1000 bezoekers nodig per variatie en heb je 100 bezoekers per dag op de betreffende pagina? Dan heb je dus minimaal 10 dagen nodig en doe je er goed aan om twee hele weken te testen. Je kunt de minimale testduur online berekenen.

Verdeling van conversies (variantie)

Hoe meer conversies je meet voor een variant, hoe nauwkeuriger je de gemiddelde conversie van die variant weet. Daarmee is ook met meer zekerheid te zeggen of een variant echt de winnaar is. Ligt de conversie voor de controlevariant tussen de 6 en 12% en voor de testvariant tussen de 9 en 13%, dan is er een grote overlap tussen conversiewaarden voor beide versies. In dat geval heb je een grotere steekproef nodig en zul je de test langer moeten laten lopen. In onderstaand voorbeeld is er geen sprake van een overlap (het grijze en het groene blokje) en kun je met zekerheid zeggen dat de variatie het beter heeft gedaan. Zorg voor een zo klein mogelijke verdeling (‘variantie’) van conversiewaarden en zo min mogelijk overlap tussen de varianten.

A/B-testen op sites met weinig verkeer

Met al deze informatie wordt testen iets ingewikkelder, maar kun je beter voorspellen of een test zin heeft. En achteraf beoordelen of de test betrouwbaar was. Maar wat als je je minimale steekproef berekend hebt en je site heeft te weinig verkeer?

Vier tips voor A/B-tests op pagina’s met weinig bezoekers:

- Test vooral grote wijzigingen

Hoe groter het effect, hoe minder conversies je nodig hebt. - Meet microconversies

Richt de test niet op een aanmelding of bestelling, maar op doorkliks naar de aanmeldingspagina of engagement op de pagina. - Test op meerdere pagina’s

Test je een element dat op veel pagina’s gebruikt wordt? Test het dan op meer pagina’s tegelijk. - Koop tijdelijk extra traffic in

Zet een tijdelijke campagne op (bijvoorbeeld in AdWords) om extra verkeer te genereren.

Nog niet genoeg verkeer?

Leveren ook deze tips nog niet genoeg verkeer op? Of moet je een maand of twee testen om hopelijk voldoende conversies te meten? Dan is A/B-testen geen handige keuze voor jouw site. Zonder betrouwbare data is het zonde om tijd in een test te steken. Steek die energie liever in het opsporen van verbeterpunten met een conversie-quickscan, usability tests, analytics, heatmaps, gebruikersfeedback of session recording en voer optimalisaties direct door!

Headerfoto: EneasMX / Wikimedia Commons

Een steekproef vind ik het beste!